专为大众而生的

一站式GenAI

落地训练及高效推论解决方案

方案介绍

量身定制,预算无压力

简单易用,一键部署

数据隐私,安全无忧

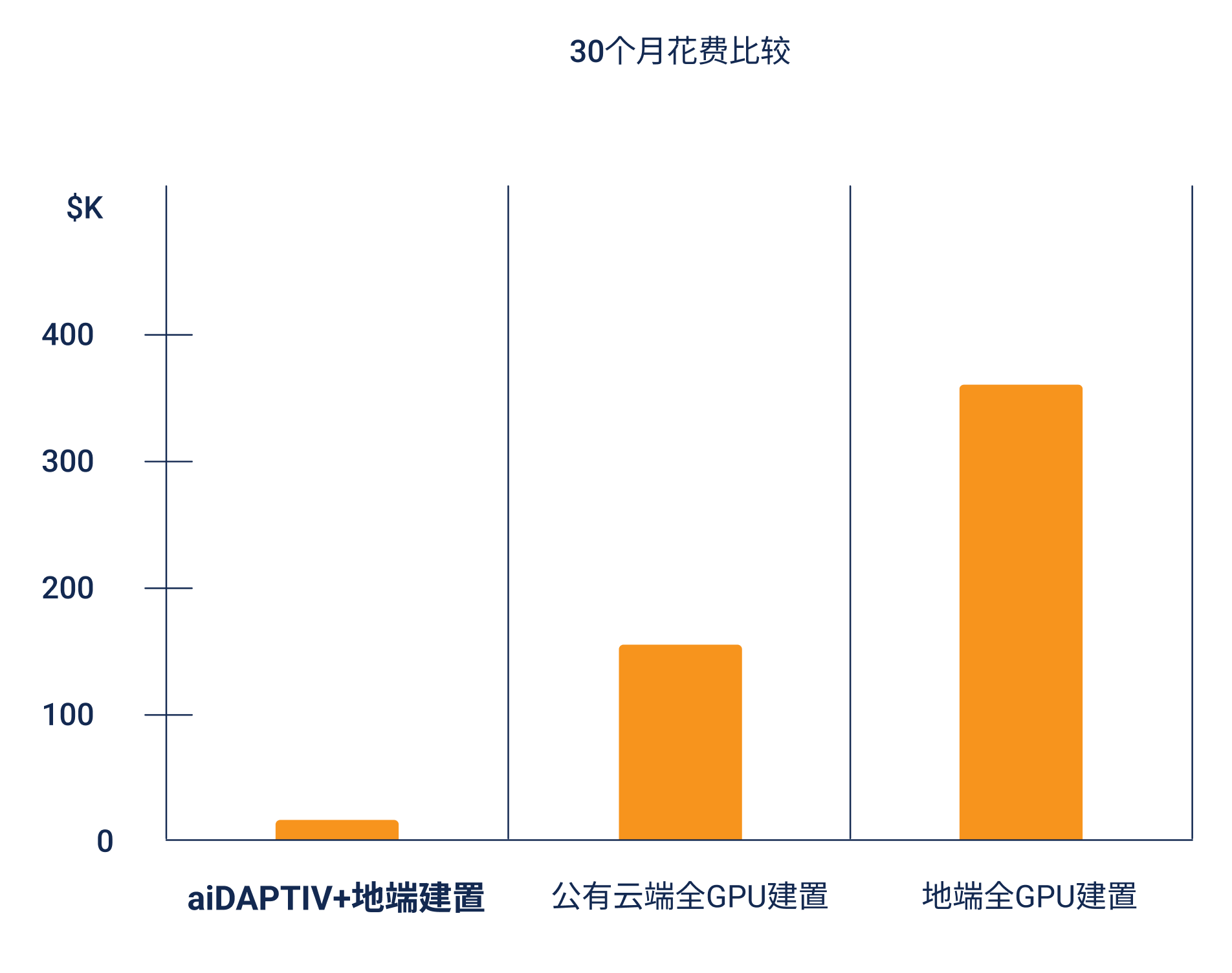

注:比较4张本地NVIDIA 6000 ADA GPU与8张云端NVIDIA H100 GPU

经济高效

aiDAPTIV+ 能够实现 HBM、GDDR 内存与成本效益更高的闪存之间的动态资源调配,有效降低硬件开支,同时大幅减少模型训练对昂贵且高耗能 GPU 显卡的依赖

轻松上手

无论在家中、办公室、教室还是数据中心,都可轻松部署。设备小巧,仅需普通电力和冷却设备即可运行。

支持命令行操作与直观图形界面,内置多种功能套件,助您轻松完成模型导入、微调、验证与推理。

数据隐私保障

支持在防火墙内进行大语言模型 (LLM) 训练,全程掌控私人数据,确保符合数据隐私合规要求,使用更安心。

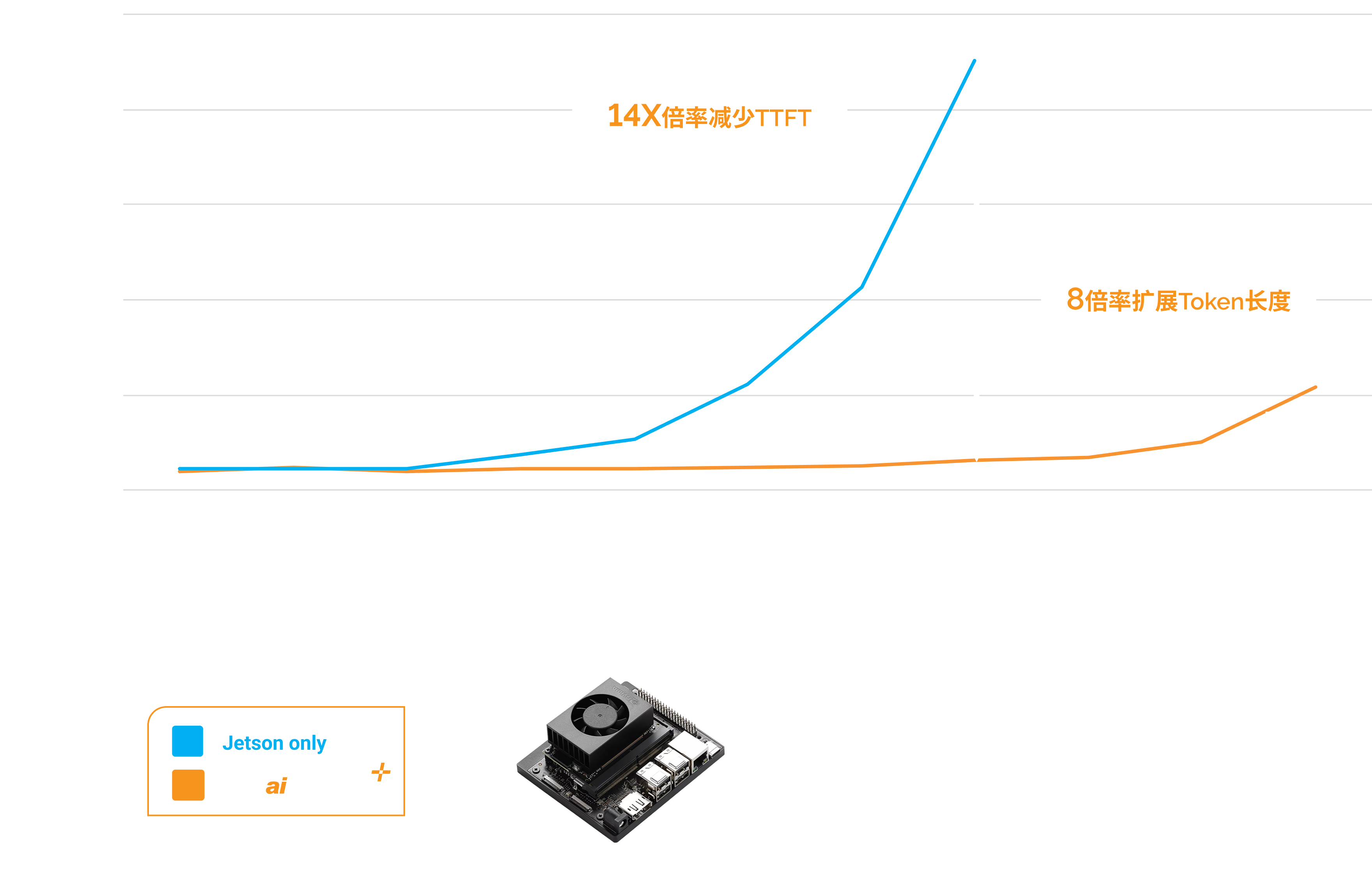

释放IoT边缘运算及机器人技术

NVIDIA Jetson IoT 设备搭载群联 aiDAPTIV+ 技术,不仅可以进行 LLM 训练,还能加速首次 token 召回的时间,提高推论性能,并通过增加 token 长度,增强上下文识别,提供更长且更精确的回答。

AI笔记本电脑

搭载 GPU 及群联 aiDAPTIV+ 技术的 AI 笔记本电脑,让用户可以在家中、办公室或教室学习如何训练 LLM。此外,您也能在本地运行训练过的 LLM,并通过模型扩充其数据,使其提供更为量身定制的推论应答。使用 aiDAPTIV+ 技术还能提升提示召回时间,并提供更多的上下文空间,进而产生更长且更精确的回复。

群联 aiDAPTIV+大语言模型训练整合方案

使用命令行或aiDAPTIV+ Pro Suite进行LLM训练

模型支持

- Llama, Llama-2, Llama-3, CodeLlama

- Vicuna, Falcon, Whisper, Clip Large

- Metaformer, Resnet, Deit base, Mistral, TAIDE

- 更多模型将持续加入

内置高效内存管理方案

体验无缝的 PyTorch 兼容性,无需调整 AI 应用程序即可轻松扩展节点。系统供应商可获得 AI100E SSD、Middleware 中间件授权及群联全方位支持,助您顺利完成系统整合

优势

- 无瑕置换

- 无需变更您的AI 应用

- 重复使用现有硬件或增加节点

aiDAPTIV+ 中间件

- 将模型分割,分配到每个GPU

- 在 aiDAPTIVCache 上暂放待处理的切片

- 将GPU上已完成的部分与待处理的切片交换

系统整合商权益

- ai100E SSD

- 中间件函式库授权

- 群联电子全方位支持服务

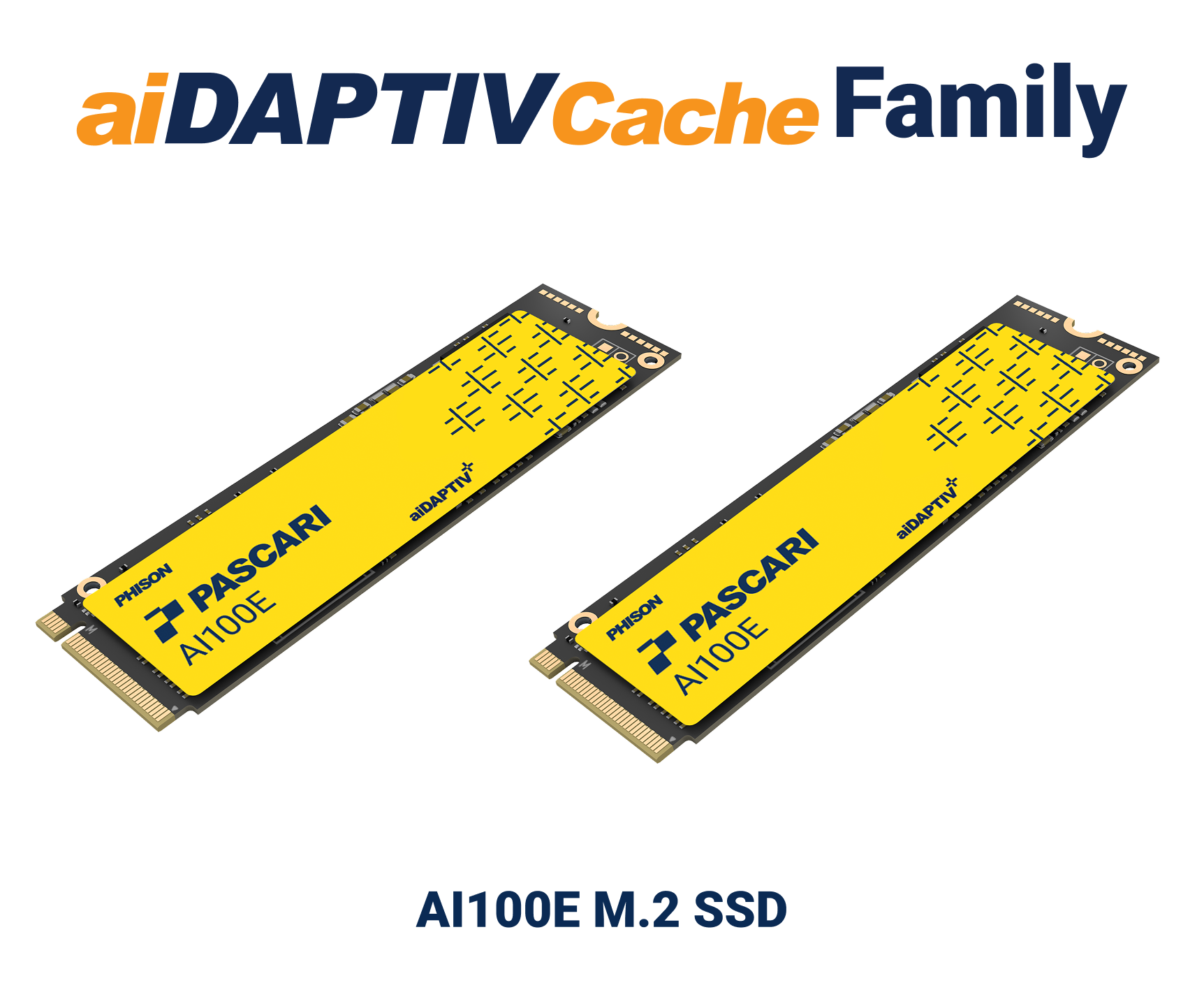

无缝扩展 GPU 内存

通过 aiDAPTIVCache 和优化的中间件扩展 GPU 内存,为 PC 提供高达 320GB 的额外容量,工作站和服务器最高可扩展至 8TB,支持低延迟 LLM 训练。同时具备行业领先的 100 DWPD 高耐用性,结合专业 SSD 设计和先进 NAND 纠错技术,提供更具竞争力的解决方案。

无缝整合

- 优化的中间件以扩展 GPU 内存容量

- 2x 2TB aiDAPTIVCache,支持70B模型

- 低延迟

高耐久度

- 业界领先,高达100次的五年内每日写入次数(DWPD)

- 采用业界先进NAND 纠错算法的SLC NAND

加强推论

aiDAPTIV+ 能通过加速首次召回 Token 的时间来实现更快速的响应,提升推理使用体验,同时延长 Token 长度,提供更丰富的上下文,从而生成更长且更准确的回答。

释放模型无限潜能

aiDAPTIV+ 通过整合闪存与 DRAM,提供更大的内存资源,使模型规模不再受限于 GPU 显卡的 HBM 或 GDDR 内存容量

这让您能够训练更大规模的模型,并以更具性价比的方式完成过去仅大型企业和云服务供应商才能承担的计算任务

其他资源

支持平台

行业支持

新闻集锦